Hablar de sistemas antispam en los resultados de búsqueda es algo de lo que he hablado muchas muchas veces en los últimos meses. Cada buscador busca sus propios sistemas para mejorar el análisis de los sitios web, ya sea mediante factores humanos, analizando las propias páginas y con decenas de métodos para aumentar la calidad del índice. Pero sin duda este sistema de Microsoft me ha sorprendido ya que se basa en el propio PageRank de Google.

La patente Locally computable spam detection features and robust pagerank de Microsoft deja bien claro que hoy en día tanto el PageRank como HITS son fácilmente manipulables, ya que se basan principalmente en los enlaces que envía y recibe un sitio y que esto ya no sirve de cara a que un sitio tenga más relevancia. Incluso, un detalle importante, es que hasta ahora los sistemas antispam debían analizar el contenido de las propias páginas una vez tuviéramos un grafo de la red de redes.

El objetivo es el de facilitar la identificación de páginas spam y de reducir la evaluación de las páginas con spam. Por ejemplo, un spammer puede intentar inflar su ranking generando una estructura de enlaces alrededor de una página concreta (granja de enlaces). Este tipo de granjas es fácilmente detectable en el grafo web. Una página tiene una cantidad de enlaces y estas páginas también tienen sus enlaces, y la suma de todos estos elementos, en su mayor o menor medida es la que genera el ranking de dicha página. De esta forma también podríamos sacar una media y ver qué elementos están por encima de ese umbral determinado. A partir del momento en el que se conocen algunas páginas marcadas como spam y otras marcadas como no-spam se podría establecer una serie de conductas que se generan de forma natural o artificial.

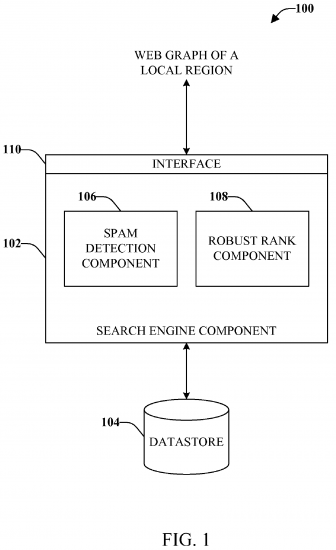

Por norma general el sistema antispam por defecto sería similar al siguiente, en el que encontramos un módulo que analiza las páginas con o sin spam, y otro que luego ordena los resultados, mayormente basado en la cantidad de enlaces que encontramos en él mismo.

Pero existe la posibilidad de integrar un componente que lo que haga es hacer ese análisis de filtrado de cantidad de enlaces en base a la limitación de la efectividad de la manipulación de enlaces. Este sistema vendría a ser similar al que Google por el cual, según ellos, en sus listados de enlaces entrantes «sólo aparecen aquellos que realmente son importantes».

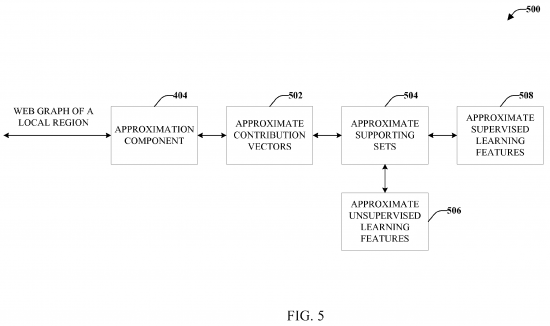

La idea final es la de encontrar la forma de integrar lo que los humanos dictaminan que es webspam con lo que las máquinas pueden aprender en lo que hace referencia a los enlaces. Es decir, un usuario dictamina que una página es spam, se analiza su «alrededor» y a partir de ahí se genera un vector en el grafo mediante el que se aprende qué se ha hecho y se aplica a otros sitios sin necesidad de saber ni analizar el contenido propio de la página, lo que ahorra tiempo al buscador, ya que no es necesario el análisis de los contenidos, algo que lleva demasiado tiempo.

La patente básicamente lo que nos ofrece es una propuesta, y aunque da ciertas pistas de por dónde quieren ir no dan datos más concretos. Aún así, sí que hacen referencia al tamaño de la información a gestionar, ya que la cantidad de niveles de enlaces entrantes puede ser desde muy reducida hasta la utilización de todo el grafo, es decir, usar todos los enlaces de Internet para analizar el spam a un sitio concreto.

Personalmente tampoco veo ninguna novedad en algo que no se esté haciendo ya por parte de todos los motores de búsqueda. Es sabido que el peso de los enlaces ha cambiado mucho y que en muchos casos las granjas de enlaces ya no sirven para mucho (lo único es saber si no afectan o afectan negativamente, algo que este sistema puede llegar a decidir), y, sobre todo, que en cualquier caso, hay que enseñar a aprender a los distintos módulos de los rastreadores e indexadores.

Deja una respuesta