Seguro que alguna vez te has preguntado ¿afectará poner Google Analytics al SEO de mi sitio? Pues ahora tenemos la respuesta oficial, y es que Google ha conseguido una patente que permite reorganizar los resultados de búsqueda parcialmente dependiendo de las estadísticas… es decir, que si Google quiere, puede. Y es que ha conseguido la Methods and apparatus for employing usage statistics in document retrieval en la que se mejoran los resultados de búsqueda dependiendo, total o parcialmente, de las estadísticas de uso.

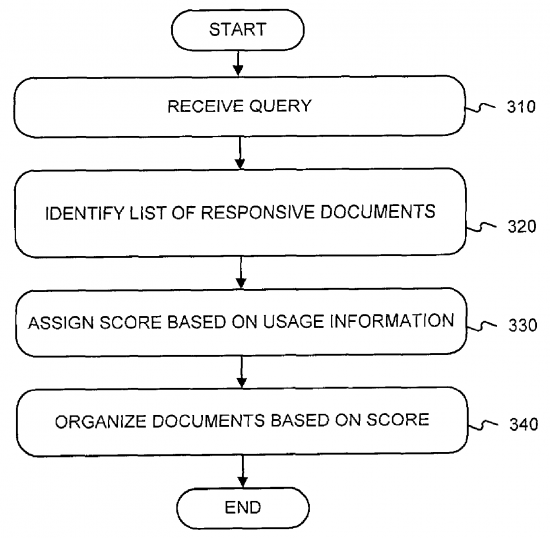

Systems and methods consistent with the present invention address this and other needs by identifying compounds based on the overall context of a user query. One aspect of the present invention is directed to a method of organizing a set of documents by receiving a search query and identifying a plurality of documents responsive to the search query. Each identified document is assigned a score based on usage information, and the documents are organized based on the assigned scores.

Internet es muy grande, y como crece también a una velocidad vertiginosa, hay que buscar nuevos métodos para elegir qué contenidos se rastrean e indexan antes que el resto. Los usuarios navegan normalmente siguiendo un grafo determinado, partiendo habitualmente de sitios de alta calidad o de motores de búsqueda. Lo bueno y lo malo de esto es que los sitios que son gestionados por humanos son difíciles de gestionar y mantener, por lo que los buscadores han de determinar de muchas maneras cuál es la relevancia correcta de estos sitios web.

Y es que la forma habitual de determinar la relevancia de un sitio es encontrando un matching entre los términos de búsqueda y el contenido de las propias páginas, además de la estructura y enlaces internos y externos del sitio. Pero estos sistemas son fácilmente manipulables por los diseñadores de sitios web, además que las páginas nuevas reciben menos enlaces que las viejas, por lo que el sistema de pesos de los enlaces también queda obsoleto.

Una consulta de búsqueda puede ser de texto, audio, vídeo o información gráfica. El buscador detecta la lista de documentos que son relevantes para esa consulta de búsqueda. La forma de identificar los documentos depende de muchos factores (como he comentado antes, los del SEO histórico), a los que habría que agregar el de uso de dicho documento, ya sea de forma total o parcial. Esto podría ser en valores absolutos o relativos al resto de documentos. La información se podría almacenar en el propio sistema de búsqueda como en sistema externos accesibles.

The usage information comprises both unique visitor information and frequency of visit information. The usage information may be maintained at client and transmitted to search engine. The location of the usage information is not critical, however, and it could also be maintained in other ways. For example, the usage information may be maintained at servers, which forward the information to search engine; or the usage information may be maintained at server if it provides access to the documents (e.g., as a web proxy).

Una vez se ha aplicado este «filtrado» y organización, los resultados se reordenan según su puntuación, ya sea de forma única por estadísticas o unido a otros factores (lo más probable). La puntuación sobre el uso del documento vendría a ser la frecuencia de la visita multiplicado por los usuarios únicos multiplicado por la navegación.

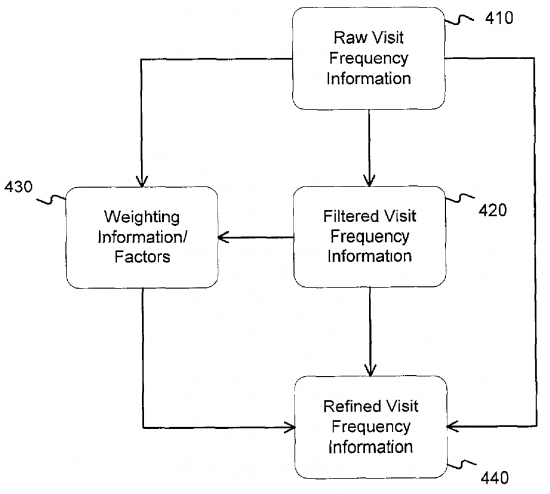

Para determinar todo este sistema se ha de tener en cuenta la información recogida directamente sobre los números absolutos o relativos de la frecuencia de visita de un documento. En este caso el RAW representaría la cantidad de veces que se ha visitado el documento, o las visitas que ha tenido en un tiempo determinado, o el cambio del número de veces que se ha visitado en un periodo de tiempo… Una vez tenemos esta información debemos filtrarla y procesar para sacar una muestra significa que sea la que realmente os aporte, eliminando «basura» de la información completa. Con toda esta información que tenemos ahora podemos sacar el peso real de la acción. Con este tipo de filtrados podríamos sacar la información según una geolocalización, el navegador, el usuario… dando más peso a las visitas de un país, idioma o cualquier otra cosa según convenga al documento o al sistema de ordenación de la «edición» del propio buscador. Es decir, si buscas en google.es las visitas de España a ese documento tendrían más peso que las visitas de Rusia.

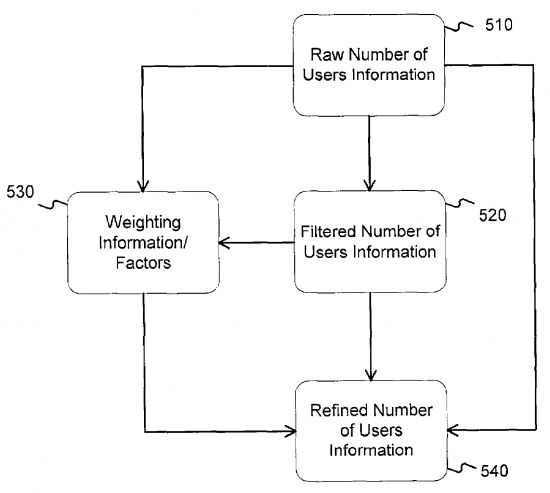

Y si antes se tenía en cuenta la frecuencia de las visitas a un documento, ahora se tienen en cuenta los propios usuarios. El funcionamiento sería exactamente el mismo que en el punto anterior, aunque aquí en vez de frecuencia tenemos usuarios. Eso sí, aquí se eliminarían los robots de búsqueda, afiliaciones, etc… cualquier cosa que elimine valor real a los datos. Aún así, volveríamos a tener datos de peso de habitantes de un lugar o de otro, si el usuario viene de una navegación de «favoritos», tráfico directo, de referencia, etc…

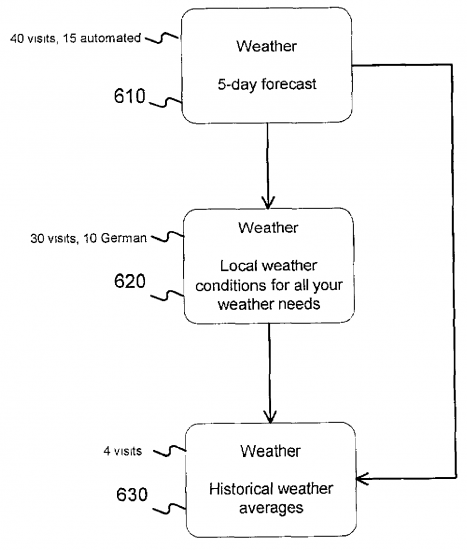

Y para acabar, un ejemplo relacionado con «el tiempo». Un documento ha sido mostrado 40 veces en el último mes, 15 visitas de ellas por sistemas automáticos. En el segundo caso 30 visitas en el último mes, 10 de ellas desde Alemania. El último documento, enlazado desde los otros dos documentos, se ha mostrado 4 veces en el último mes. Según esto, tenemos que el primer documento tiene 3 veces la palabra «weather», el siguiente 2 veces y el último 1 vez.

Si siguiéramos el sistema de ordenación tradicional, el que ordena según el número de enlaces, los documentos se ordenarían 3º (2 enlaces entrantes), 2º (1 enlace entrante) y 1º (sin enlaces entrantes). Pero siguiendo el sistema nuevo que utiliza datos de uso (en este caso sin filtrar) tendríamos: el 1º (tiene 40 visitas), el 2º (tiene 30 visitas) y el 3º (tiene 4 visitas). Pero si aplicásemos un sistema de filtrado en el que se eliminan los robots y se da el doble de peso a los usuarios de Alemania, tendríamos una ordenación tal que: 2º (40 visitas, 10 de Alemania que cuentan doble), 1º (25 visitas, eliminando las 15 de robots) y 3º (4 visitas).

Sin duda el planteamiento y las posibilidades son enormes ya que tiene cierta lógica dar peso a páginas que ya tienen muchas visitas, pero eso también implicaría que sólo los sitios con mucho tráfico aparecieran en los primeros puestos de búsquedas, algo que degradaría de forma automática a aquellos nuevos sitios que aparecen en la red de redes.

Deja una respuesta