De nuevo otra patente concedida a Google ayer mismo vuela sobre nuestras cabezas… se llama Document near-duplicate detection y se solicitó en 2009, hace tan sólo año y medio. Aún así hay que tener en cuenta que existe ya una patente previa llamada de la misma forma, ororgada a mediados del año pasado pero «creada» en 2004, lo que significaría que desde 2004 Google está detectando los duplicados, aunque hace menos de 2 años que solicitó una actualización del algoritmo.

¿Qué es lo que la patente reclama? Pues algo tal que así:

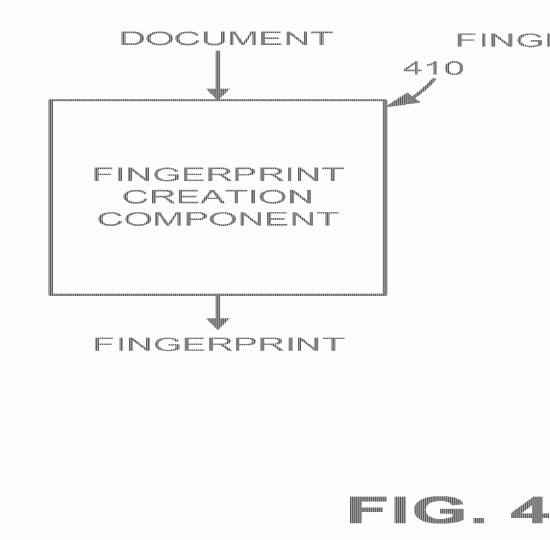

A near-duplicate component includes a fingerprint creation component and a similarity detection component. The fingerprint creation component receives a document of arbitrary size and generates a compact «fingerprint» that describes the contents of the document. The similarity detection component compares multiple fingerprints based on the hamming distance between the fingerprints. When the hamming distance is below a threshold, the documents can be said to be near-duplicates of one another.

Que viene a decir lo siguiente:

Un componente de duplcación cercana incluye un componente de creación de huella digital y un componente de detección de similitud. El componente de creación de la huella digital recibe un documento de tamaño arbitrario y genera una «huella digital» compacta que describe el contenido del documento. El componente de detección de similitud compara las múltiples «huellas digitales» basadas en la distancia entre las mismas. Cuando la distancia está por debajo de un umbral, los documentos se puede decir que casi duplica el uno del otro.

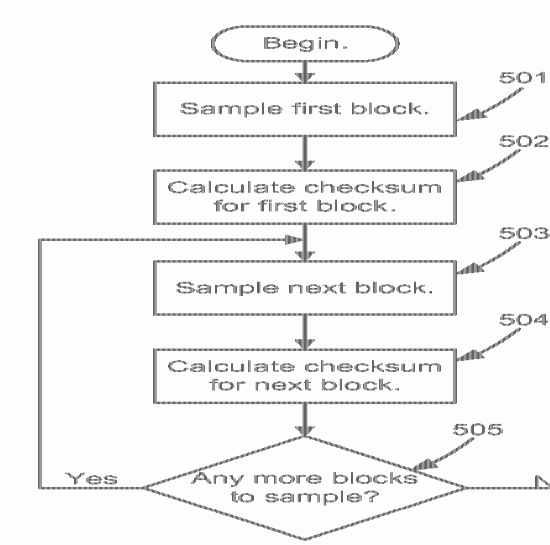

¿Qué es lo que dice el sistema? Pues que para cada documento se crea una especie de resumen del mismo, según su longitud, y que este pequeño resumen tendría las partes más destacadas de todos los fragmentos del texto (lo que podrían ser algunas frases que luego se puedan comprara con otros documentos). Una vez se tiene creado este tipo de resumen se crea un sistema que compare estos fragmentos para detectar relaciones entre ellos. Gracias a esto el buscador sólo almacenaría e indexaría una de estas copias.

Este sistema también permitiría detectar bloques parciales de la información de los contenidos, por lo que los contenidos duplicados no tienen porqué ser una página al completo, sino que puede considerarse un fragmento de esos bloques.

El sistema lo que haría es relacionar aquellas páginas copiadas con la versión original y en este caso en los resultados de búsqueda mostraría tan sólo la fuente original (algo parecido a lo que se viene haciendo en Google Noticias en la actualidad).

Hasta aquí tendríamos el cómo funciona el sistema, que básicamente es lo comentado: se crean unos bloques destacados de cada parte de un contenido global, se codifica y luego se compara de una forma rápida con otros nuevos documentos. Todo, en base a que no se almacenen copias inútiles de los mismos contenidos y así economizar.

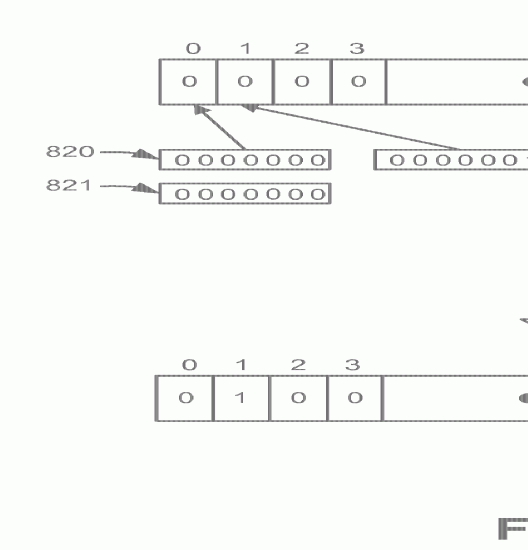

For example, the hamming distance between 1011101 and 1001001 is two. For a 128 bit fingerprint, a hamming distance of 18 may be used to distinguish whether two documents are near-duplicates, i.e., a hamming distance less than or equal to 18 can indicate near-duplicate documents, otherwise, the documents are considered non-near-duplicates. One of ordinary skill in the art will recognize that other threshold levels could be used depending on the particular application.

Lo interesante de este sistema es que los falsos negativos son bajos, pero los falsos positivos son altos a gran escala, pero a pequeña es todo lo contrario. El falso negativo se definiría como dos paginas similares que sus «huellas» tienen una gran distancia. Un falso positivo serían dos páginas aleatorias que tienen una distancia pequeña. Eso sí, en principio al tomar una gran muestra, la posibilidad de ambos casos tiende a ser la misma. Eso sí, las muestras pueden ser generalistas o concretas, como decía antes, de un tipo de contenido concreto, como son las noticias.

En fin, tampoco es que se explique gran cosa sobre cómo se detectan los contenidos duplicados, sino que hablan de la metodología que se utiliza, que en este caso es la de crear «huellas» para cada uno de los fragmentos de un texto… eso sí, lo que no me queda claro es la influencia que podría tener la parte HTML (el diseño o maquetación) en la detección de estos duplicados.

Deja una respuesta