Interesante propuesta la que hace Yahoo! para mejorar los resultados de búsqueda y no depender tanto de conceptos como el PageRank o de la navegación que hacen los usuarios a través de las propias páginas de resultados, y es la de usar los logs de navegación de los ISP.

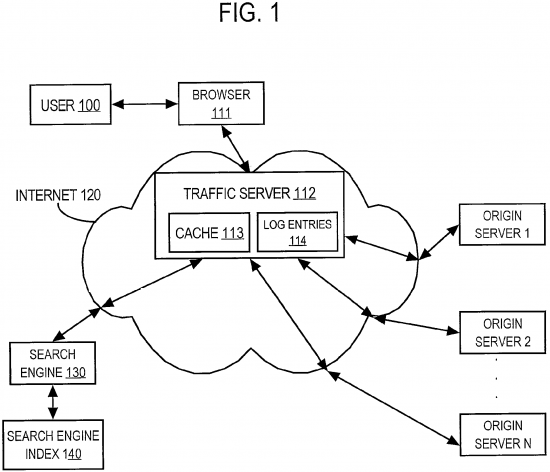

Antes de seguir pongámonos en antecedentes para aquellos que no tengan muy claro cómo funciona la navegación del usuario. Un usuario está en su casa delante de su navegador de Internet y con su proveedor de Internet (cable, ADSL, etc…). El proveedor lo que hace es de intermediario entre tu casa y los servidores donde se encuentran las páginas web que visitas. Por ejemplo, ahora que estás visitando javiercasares.com has de conectarte con (por ejemplo) Telefónica, que va a tu central de telefonía, de allí se conecta a su central de datos y, a través de ciertos routers acaba enviando la información a mi máquina (alojada cerca de Barcelona) que responde y se vuelve a hacer el camino inverso, a través de ciertos routers que devuelven esta página a tu navegador.

Ahora que sabemos más o menos cómo funciona esto podemos ver claramente que esos routers por los que pasa la información podrían (y en algunas ocasiones lo hacen) guardar información (anónima o no) de qué páginas se está visitando. Esto es, por ejemplo, lo que hacen servicios tipo Alexa, que analizan cierta información de la red de redes para saber qué páginas se visitan más. Pues Yahoo! lo que propone (con su patente Using network traffic logs for search enhancement) es analizar esos logs y de esa forma, teniendo en cuenta por las páginas por las que los usuarios navegan (o se leen feeds y cualquier cosa que incluya transporte de información) mejorar los resultados de búsqueda y, sobre todo, descubrir nuevas URL que no se tenían indexadas.

Techniques are provided for using network traffic logs for search enhancement. According to various aspects of the invention, data extracted from network usage logs is used in a variety of ways, including:

1) the ranking of a URL in the search results are improved by using the number of times a URL is present in the network traffic logs as an indication of popularity;

2) the list of URLs saved in the search engine index can be improved by including some or all URLs that are present in the network traffic logs;

3) the breakup of a search index into tiers can be improved by taking into account the number of times a URL is present in the network traffic logs;

4) the number of times a URL is present in the network traffic logs can be used to assign weights to links, where the link weights are used to determine popularity and the indexing of pages; and

5) the traffic log information may be used to determine which web pages have been modified since the search engine index was last updated.

These techniques may be used to improve the relevance ranking, indexing and searching of Internet-wide search engines, as well as search engines that are restricted to specific domains or private intranets.

Y es que tal y como Yahoo! comenta, encontrar la relevancia de un sitio es bastante complejo y hay muy pocos datos a tener en cuenta. Y es que una página puede ser muy popular entre los usuarios pero no serlo en los motores de búsqueda. Un ejemplo podría ser que alguien crea un sitio con pocos enlaces entrantes pero gracias al reenvio de correos electrónicos ese sitio se vuelve muy popular. Como el sitio sólo utiliza los pocos enlaces existentes para posicionarla, sigue siendo un sitio «poco relevante» de cara a los buscadores, aunque sí que lo es de cara a los usuarios.

Si se usa un sistema como el que se propone de analizar las páginas por las que los usuarios van navegando sí que se podría tener en cuenta la cantidad de visitas del sitio a la hora de posicionarla.

Este sistema, aunque de una forma distinta, es el que propiamente se usa con Google Analytics, ya que Google tiene los datos propios de navegación de cada sitio, y es capaz de detectar aquellos sitios nuevos o los que de golpe tienen una subida de tráfico.

Deja una respuesta